What is LLM Explorer?

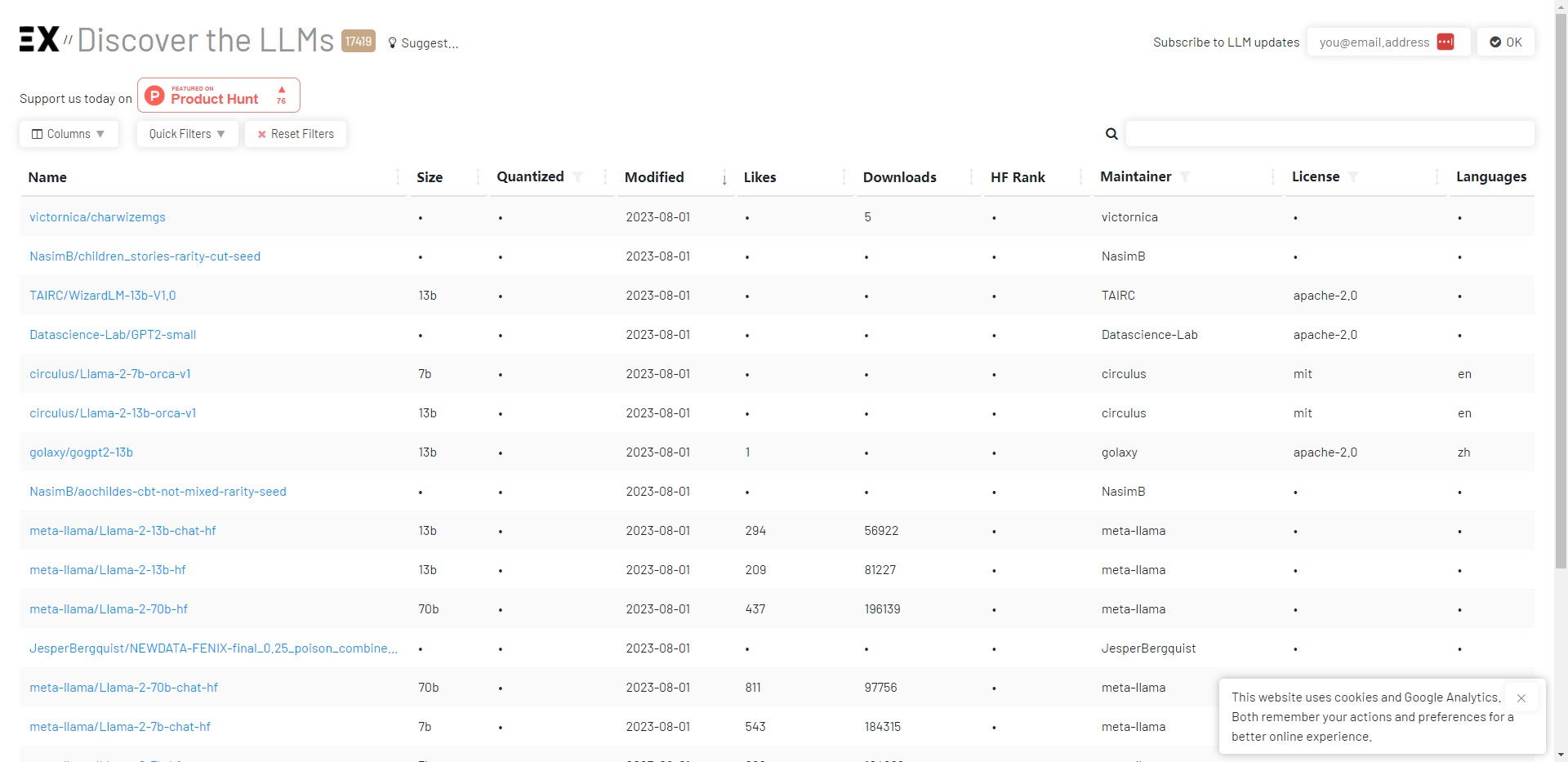

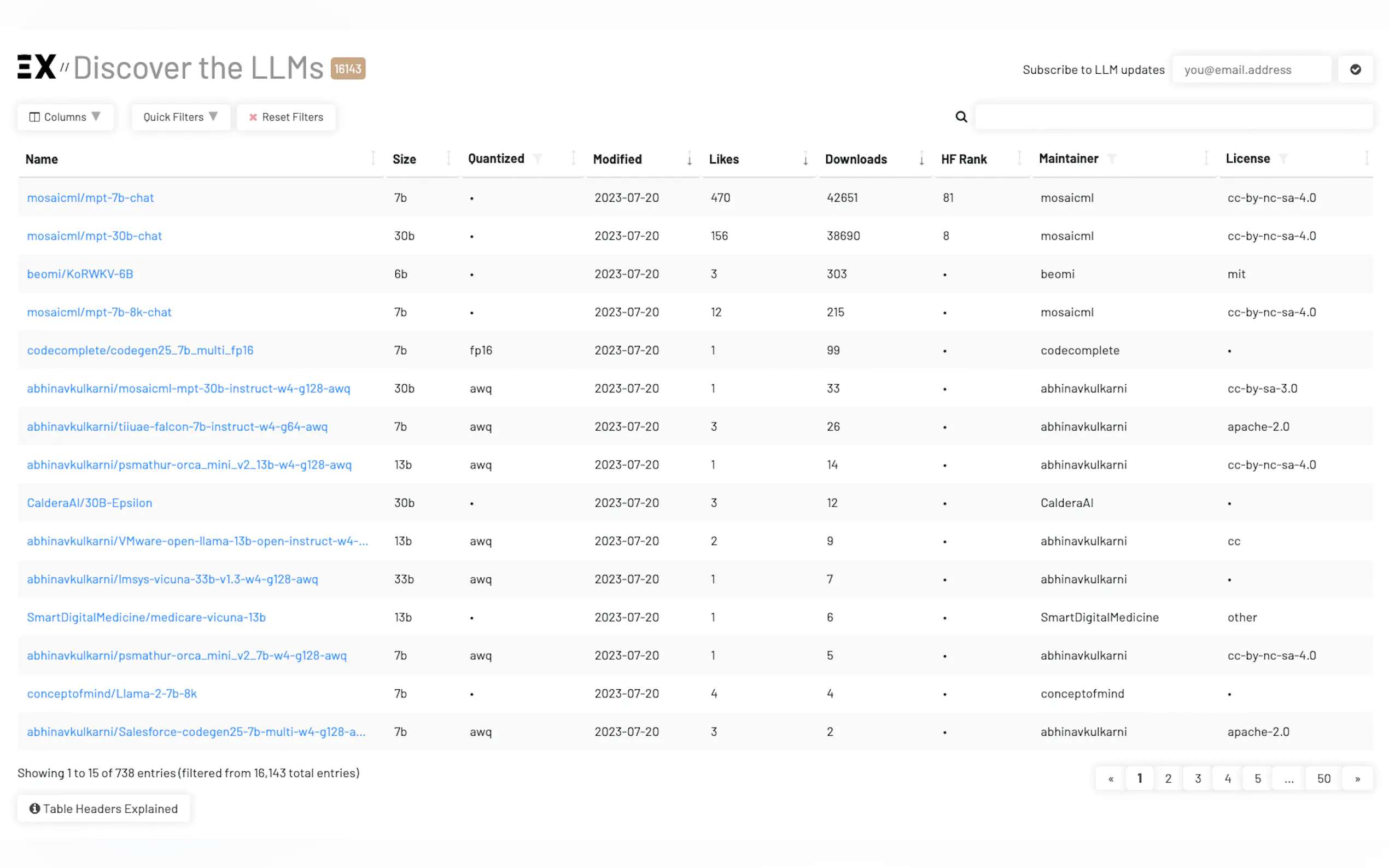

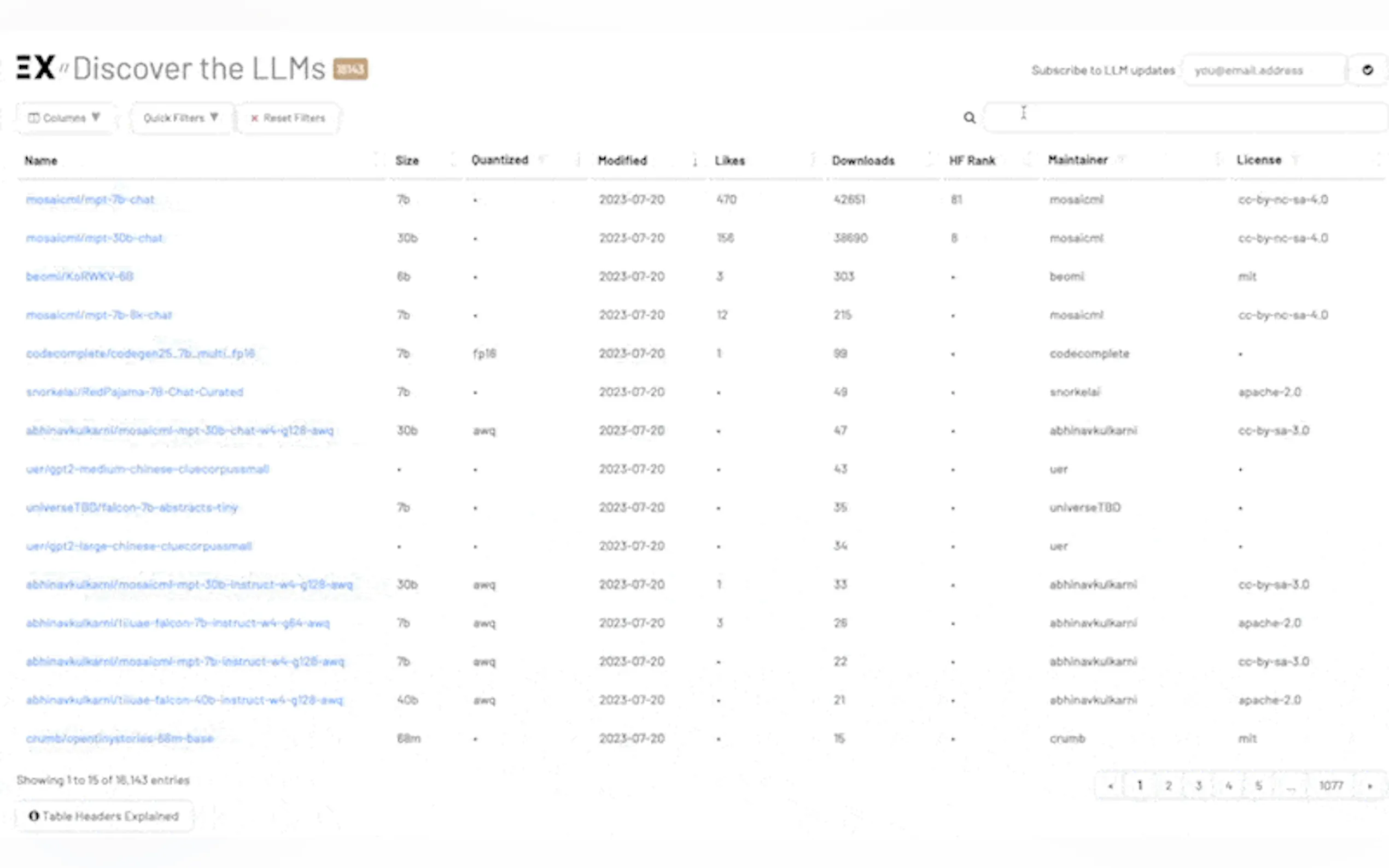

LLM Extractum, développé par TABLUM, est un outil convivial qui simplifie le processus d'exploration, de comparaison et de classement des modèles de langage volumineux (LLM). Grâce à son interface interactive, les utilisateurs peuvent facilement sélectionner le LLM le mieux adapté à leurs besoins, ce qui profite aux chercheurs en apprentissage automatique, aux développeurs et aux passionnés d'IA.

Fonctionnalités clés :

1. Interface intuitive : LLM Extractum offre une plateforme dynamique et interactive pour découvrir, comparer et classer les LLM, ce qui permet aux utilisateurs de naviguer facilement et de trouver le bon modèle.

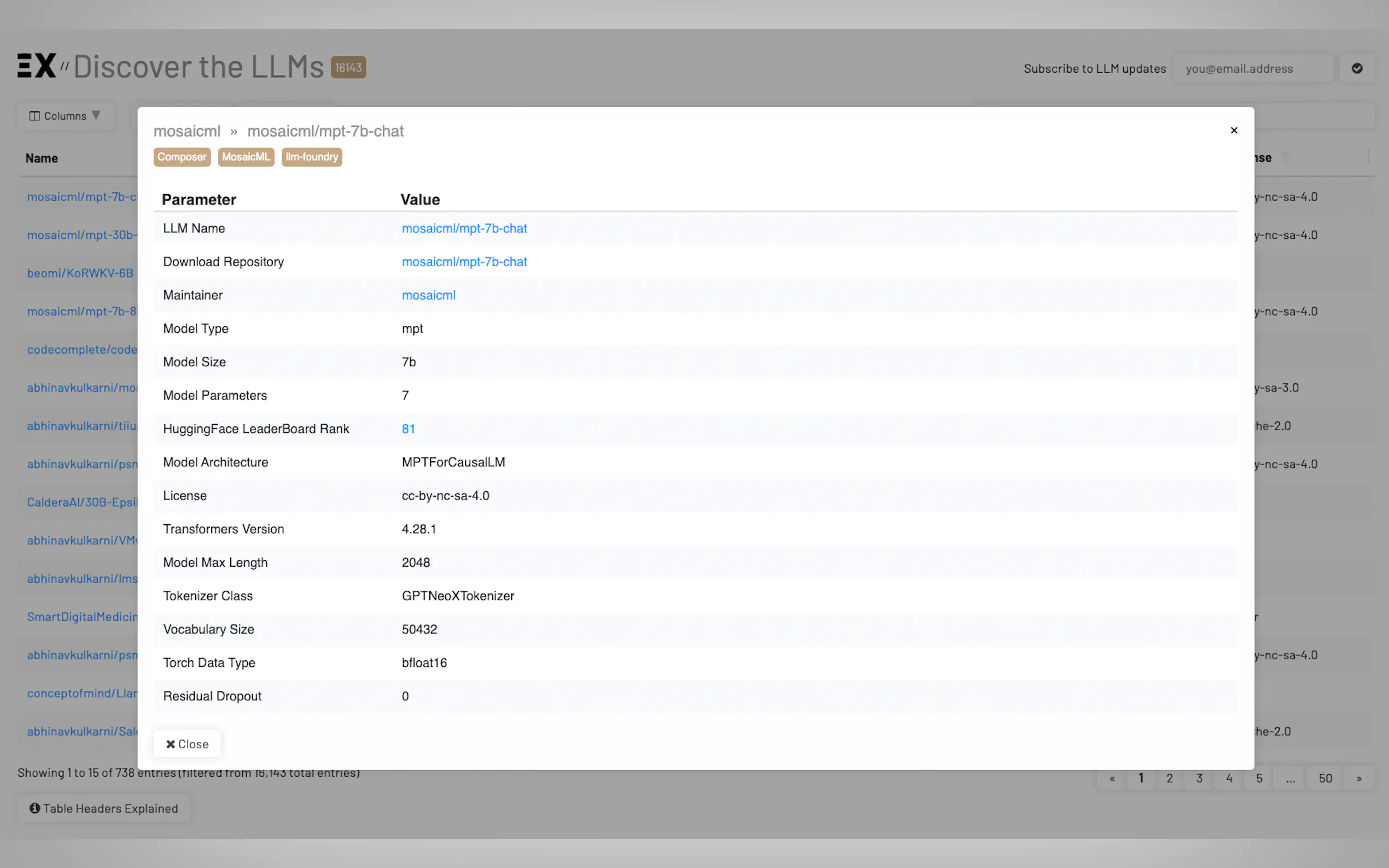

2. Informations détaillées : les utilisateurs ont accès à des informations complètes sur chaque LLM, notamment son architecture, sa capacité linguistique et sa longueur de contexte, ce qui leur permet de prendre des décisions éclairées.

3. Processus de sélection simplifié : cet outil simplifie la tâche complexe consistant à choisir le LLM le plus approprié, ce qui permet aux chercheurs, aux développeurs et aux passionnés d'IA de gagner du temps et des efforts.

Cas d'utilisation :

1. Recherche et développement : LLM Extractum permet aux chercheurs en apprentissage automatique d'explorer et de comparer efficacement différents LLM, ce qui contribue au développement d'applications d'IA innovantes.

2. Sélection de modèles : les développeurs peuvent utiliser cet outil pour identifier facilement le LLM le mieux adapté aux exigences spécifiques de leur projet, ce qui améliore la précision et les performances de leurs systèmes d'IA.

3. IA accessible : LLM Extractum démocratise la technologie de l'IA en fournissant une interface conviviale, ce qui permet aux individus ayant des connaissances techniques variables d'exploiter la puissance des LLM pour leurs applications.

Conclusion :

LLM Extractum révolutionne la façon dont nous interagissons avec les LLM en offrant une plateforme simple mais puissante pour explorer, comparer et classer ces modèles. Grâce à son interface intuitive, à ses informations détaillées et à son processus de sélection simplifié, cet outil permet aux chercheurs, aux développeurs et aux passionnés d'IA de prendre des décisions éclairées et de stimuler l'innovation dans les applications d'IA. En démocratisant l'accès à la technologie de l'IA, LLM Extractum ouvre la voie à un paysage de l'IA plus inclusif et diversifié.

More information on LLM Explorer

Top 5 Countries

Traffic Sources

LLM Explorer Alternatives

Plus Alternatives-

-

-

-

Découvrez la puissance de VerifAI, le guide ultime pour comparer les réponses des LLM. Des évaluations précises, des paramètres variés et une analyse multidimensionnelle pour des décisions éclairées.

-

LM Studio est une application de bureau intuitive, conçue pour faciliter l'expérimentation avec les Large Language Models (LLM) locaux et open-source. Cette application multiplateforme vous offre la possibilité de télécharger et d'exécuter n'importe quel modèle compatible ggml directement depuis Hugging Face. Elle intègre une interface utilisateur (UI) pour la configuration et l'inférence des modèles, se distinguant par sa simplicité d'accès et sa puissance. De plus, elle tire pleinement parti de votre GPU lorsque les conditions le permettent.