What is LLMLingua?

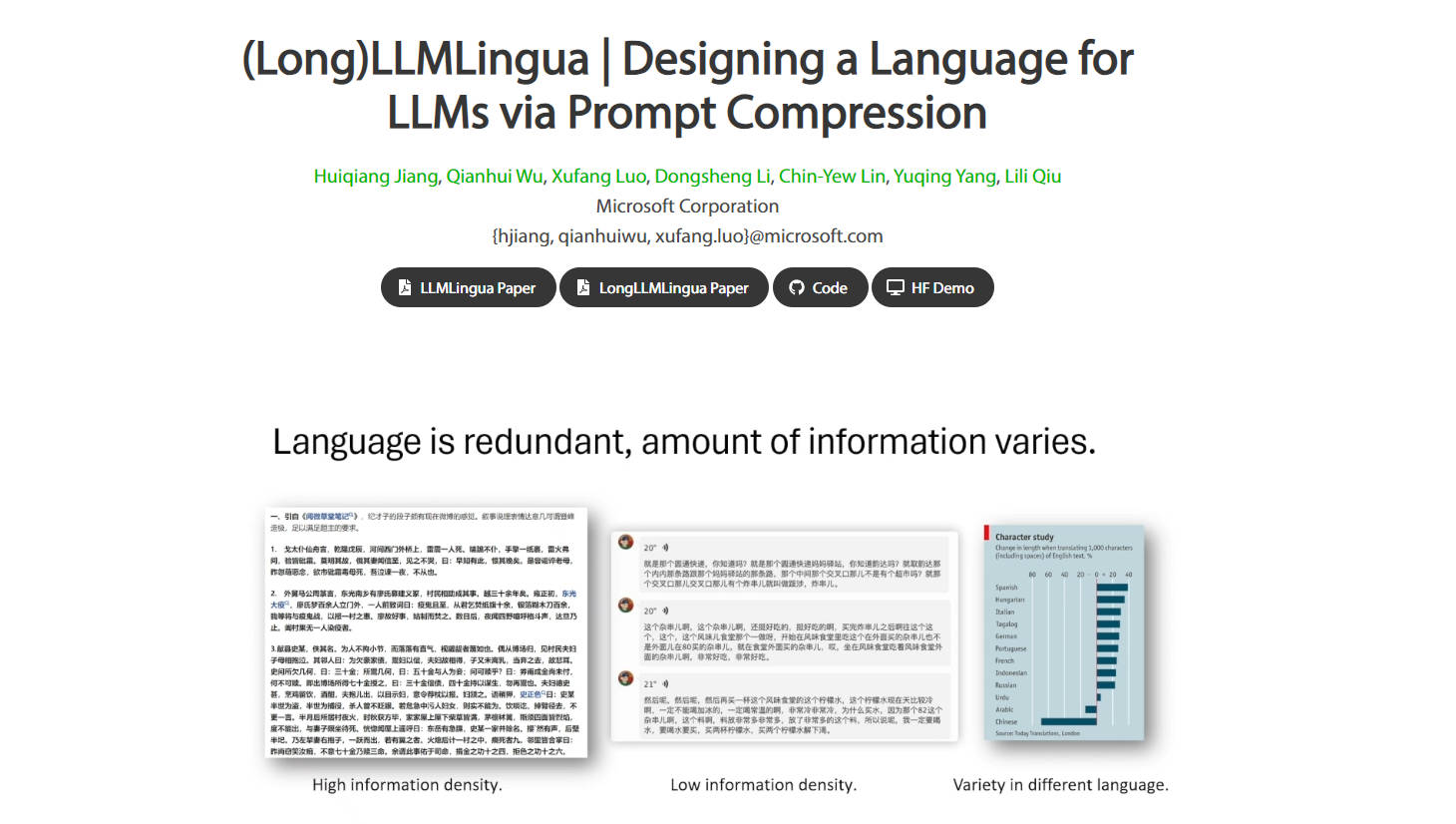

LLMLingua est un outil d'IA qui améliore les performances des modèles de langage volumineux (LLM) en compressant les invites. Il permet d'obtenir jusqu'à 20 fois plus de compression avec une perte de performance minimale, ce qui permet d'optimiser les inférences et de réduire les coûts. Avec LLMLingua, les utilisateurs peuvent surmonter les limites de longueur d'invite, améliorer la prise en charge des contextes plus longs et conserver les informations d'invite d'origine.

Fonctionnalités principales :

? Réduction des coûts : réduit la longueur des invites et des générations, ce qui permet d'utiliser les modèles d'IA de manière rentable.

? Prise en charge de contextes étendus : améliore la prise en charge des contextes plus longs, atténue le problème de « perte au milieu » et améliore les performances globales.

⚖️ Robustesse : aucune formation supplémentaire n'est nécessaire pour les LLM, ce qui facilite l'intégration de LLMLingua dans les modèles existants.

Cas d'utilisation :

LLMLingua est utile pour résumer des textes longs avec ChatGPT, en surmontant les limites de jetons et en garantissant des résumés précis et concis.

Il est utile pour conserver les instructions et le contexte lors du réglage fin des modèles de langage, ce qui empêche l'oubli et améliore les performances du modèle.

LLMLingua permet de réaliser des économies lors de l'utilisation de l'API GPT3.5/4 pour des expérimentations, ce qui permet aux chercheurs d'obtenir d'excellents résultats sans dépenses importantes.

Conclusion :

LLMLingua offre une solution puissante pour améliorer les modèles de langage volumineux. En compressant les invites, il permet d'optimiser les inférences, d'améliorer la prise en charge des contextes plus longs et de réduire les coûts. Avec LLMLingua, les utilisateurs peuvent maximiser l'utilité des LLM sans sacrifier les performances ni alourdir le budget.

More information on LLMLingua

Top 5 Countries

Traffic Sources

LLMLingua Alternatives

Plus Alternatives-

-

-

-

Nous sommes désormais en prévisualisation publique ! Teammate Lang est une solution tout-en-un pour les développeurs et opérateurs d'applications LLM. Éditeur sans code, cache sémantique, gestion des versions d'invite, plateforme de données LLM, tests A/B, assurance qualité, terrain de jeu avec plus de 20 modèles, dont GPT, PaLM, Llama, Cohere.

-