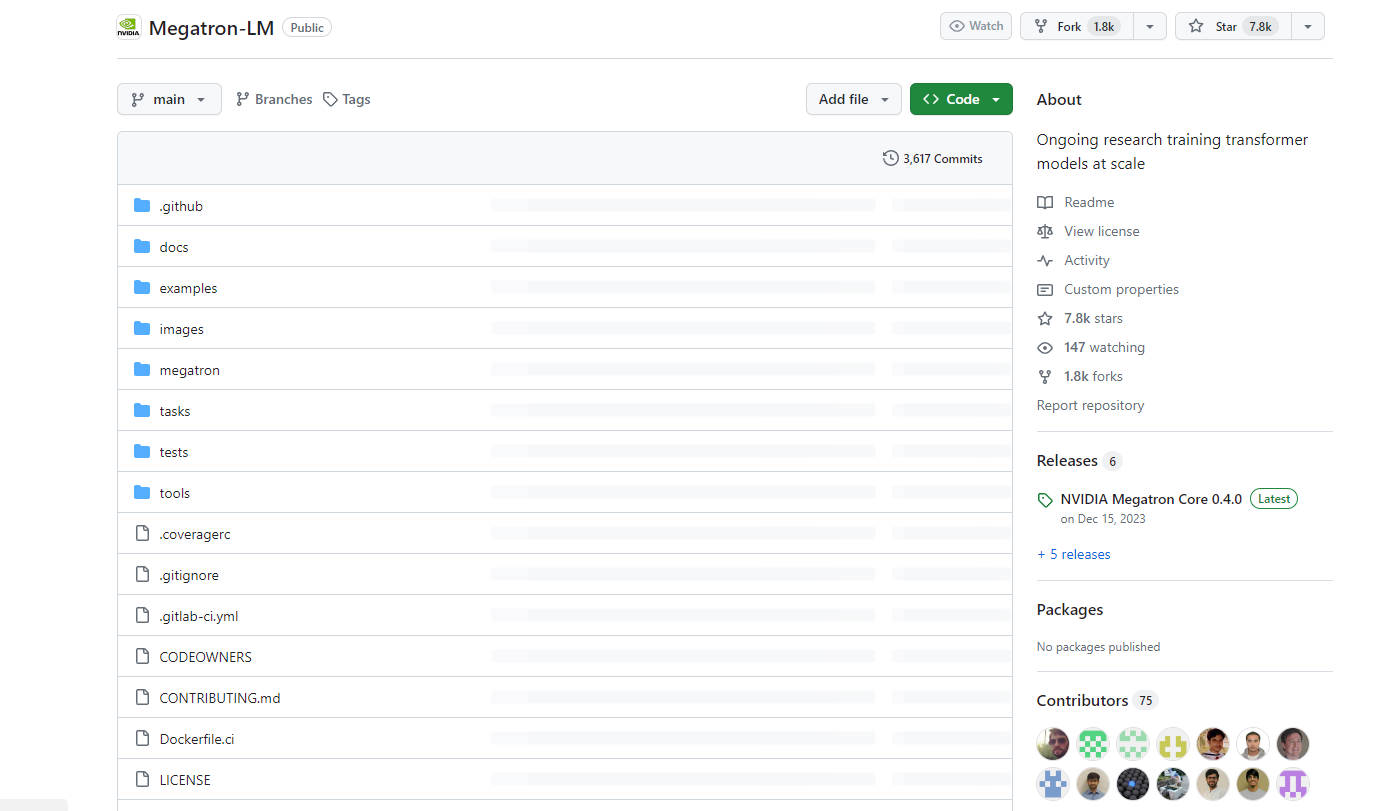

What is Megatron-LM?

Megatron est un puissant transformateur développé par NVIDIA pour entraîner des modèles de langage de grande envergure à grande échelle. Il offre des capacités de pré-apprentissage parallèles et multi-nœuds efficaces pour des modèles tels que GPT, BERT et T5. Avec Megatron, les entreprises peuvent relever les défis de la création et de l'entraînement de modèles sophistiqués de traitement du langage naturel avec des milliards et des billions de paramètres.

Principales caractéristiques :

? Entraînement efficace : Megatron permet l'entraînement efficace de modèles de langage avec des centaines de milliards de paramètres en utilisant à la fois le parallélisme de modèle et de données.

? Parallélisme de modèle : il prend en charge le parallélisme de modèle tensoriel, séquentiel et pipeline, permettant la mise à l'échelle des modèles sur plusieurs GPU et nœuds.

? Pré-apprentissage polyvalent : Megatron facilite le pré-apprentissage de divers modèles basés sur des transformateurs tels que GPT, BERT et T5, permettant le développement de modèles de langage génératifs à grande échelle.

Cas d'utilisation :

? Modélisation du langage : Megatron est utilisé pour le pré-apprentissage de modèles de langage à grande échelle, permettant la création de modèles puissants pour des tâches telles que la génération de texte, la traduction et la synthèse.

?️ Recherche d'informations : il est utilisé pour entraîner des récupérateurs neuronaux pour répondre à des questions à domaine ouvert, améliorant la précision et la pertinence des résultats de recherche.

? Agents conversationnels : Megatron alimente les agents conversationnels en permettant la modélisation de dialogue génératif multi-acteurs à grande échelle, améliorant la qualité et le naturel des conversations automatisées.

Conclusion :

Megatron est un outil d'IA de pointe développé par NVIDIA, conçu pour entraîner des modèles de transformateurs de grande envergure à grande échelle. Grâce à ses capacités d'entraînement efficaces, à sa prise en charge du parallélisme de modèle et à sa polyvalence dans le pré-apprentissage de divers modèles de langage, Megatron permet aux entreprises de créer et d'entraîner des modèles de traitement du langage naturel sophistiqués avec des performances et une précision exceptionnelles. Qu'il s'agisse de modélisation du langage, de recherche d'informations ou d'agents conversationnels, Megatron est un atout précieux pour les chercheurs et les développeurs en IA.

More information on Megatron-LM

Megatron-LM Alternatives

Plus Alternatives-

KTransformers, un projet open source de l'équipe KVCache.AI de Tsinghua et de QuJing Tech, optimise l'inférence des grands modèles de langage. Il réduit les seuils matériels, permet d'exécuter des modèles de 671 milliards de paramètres sur des GPU uniques de 24 Go de VRAM, accélère la vitesse d'inférence (jusqu'à 286 tokens/s en pré-traitement, 14 tokens/s en génération) et convient à un usage personnel, professionnel et académique.

-

Transformer Lab : Une plateforme open-source pour construire, affiner et exécuter des LLM localement sans coder. Téléchargez des centaines de modèles, affinez-les sur différents matériels, discutez, évaluez, et bien plus encore.

-

MonsterGPT: Peaufinez et déployez des modèles d'IA sur mesure via le chat. Simplifiez les tâches complexes de LLM et d'IA. Accédez facilement à plus de 60 modèles open-source.

-

Nemotron-4 340B, une famille de modèles optimisés pour NVIDIA NeMo et NVIDIA TensorRT-LLM, comprend des modèles d'instructions et de récompenses de pointe, ainsi qu'un ensemble de données pour l'entraînement de l'IA générative.

-