What is Ollama Docker?

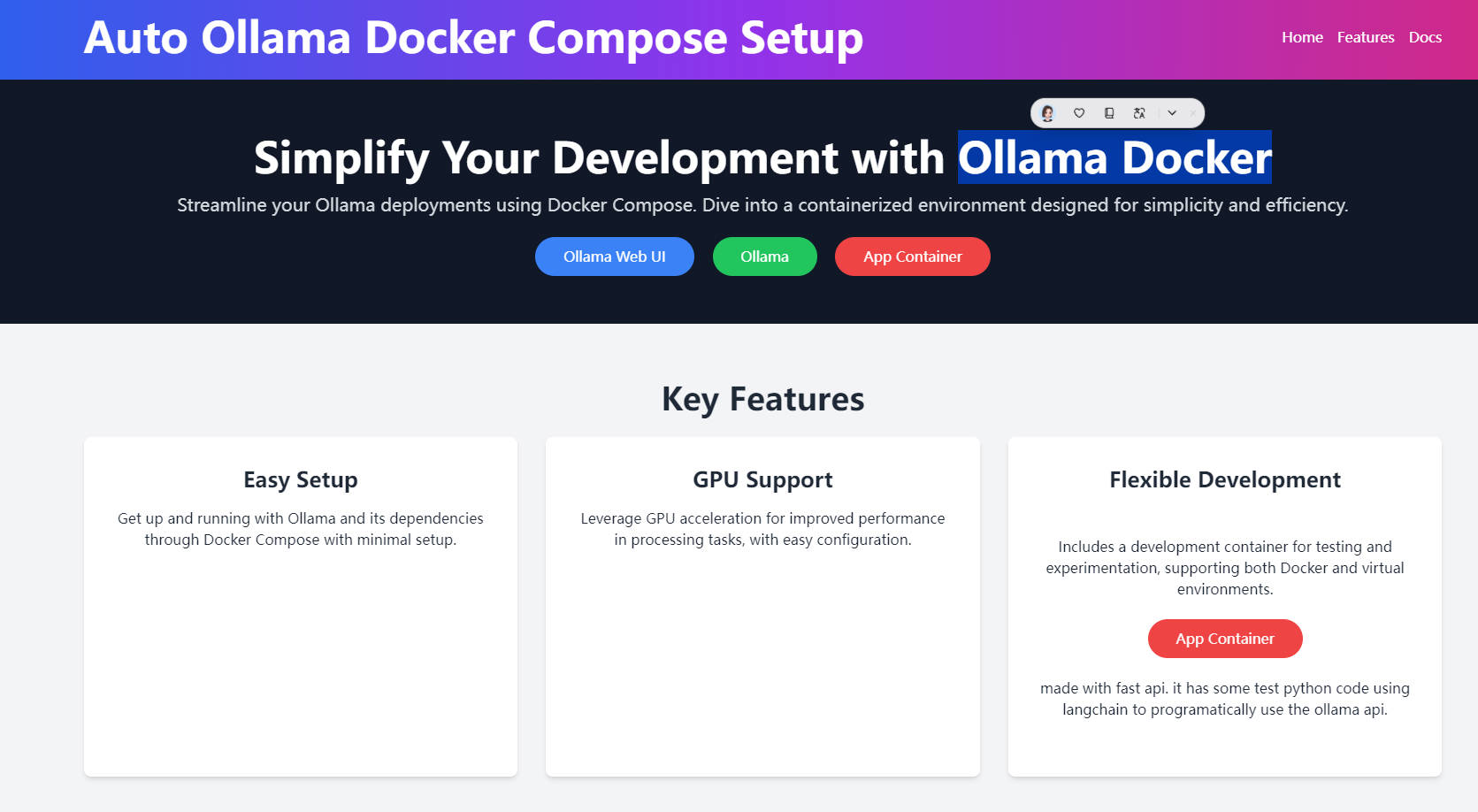

Plongez dans l'avenir du développement de l'IA avec Ollama Docker, un environnement conteneurisé pionnier conçu pour rationaliser vos déploiements et vous doter d'une accélération GPU. Conçu pour une configuration aisée, des capacités de développement polyvalentes et une interface utilisateur Web intuitive, Ollama Docker élève votre flux de travail, permettant des tâches de traitement plus rapides et plus efficaces ainsi qu'une intégration transparente à vos projets.

Fonctionnalités clés :

Configuration facile : Avec Docker Compose, le déploiement d'Ollama et de ses dépendances est un jeu d'enfant, garantissant que votre système est opérationnel avec un minimum d'effort.

Prise en charge du GPU : Bénéficiez de performances accrues dans le traitement des tâches grâce à l'intégration de l'accélération GPU, configurable en toute transparence via NVIDIA Container Toolkit.

Développement flexible : Un conteneur dédié prend en charge vos besoins de développement, offrant un environnement pour les tests et l'expérimentation, que vous préfériez Docker ou des environnements virtuels.

Conteneur d'application optimisé pour FastAPI : Ce conteneur, construit avec FastAPI, inclut du code Python de test utilisant Langchain pour une approche programmatique de l'utilisation de l'API Ollama, facilitant l'expérimentation et le développement rapides.

Cas d'utilisation :

Développement rapide d'applications d'IA : Les développeurs peuvent rapidement prototyper des applications d'IA à l'aide des modèles pré-entraînés d'Ollama, accélérant le cycle de développement.

Recherche éducative en IA : Les universités peuvent exploiter Ollama Docker pour fournir aux étudiants des environnements accélérés par le GPU, améliorant les capacités d'apprentissage et de recherche en IA.

Tests d'IA basés sur le cloud : Les entreprises peuvent utiliser Ollama Docker pour déployer des modèles d'IA dans le cloud à des fins de test et d'évaluation, sans avoir besoin d'une infrastructure GPU locale.

Conclusion :

Ollama Docker est la pierre angulaire d'un développement d'IA efficace, offrant un environnement transparent, alimenté par le GPU et convivial pour le développement. Que vous soyez un développeur qui souhaite accélérer la création d'applications d'IA ou un éducateur qui cherche à améliorer le programme d'études en IA, Ollama Docker est votre clé pour déverrouiller de nouvelles possibilités. Commencez à explorer ses capacités dès aujourd'hui et transformez votre façon de travailler avec l'IA.

FAQ :

Q : Que propose Ollama Docker aux développeurs intéressés par l'IA ?

A :Ollama Docker fournit un environnement prêt à l'emploi pour le développement de l'IA, proposant une configuration facile, la prise en charge du GPU et un conteneur de développement flexible optimisé pour les tests et l'expérimentation, accélérant le processus de développement de l'IA.

Q : Puis-je utiliser Ollama Docker à des fins éducatives ?

A :Absolument, Ollama Docker est un excellent outil pour les milieux éducatifs, offrant des environnements accélérés par le GPU qui améliorent l'apprentissage et la recherche en IA pour les étudiants et les éducateurs.

Q : Comment Ollama Docker prend-il en charge les tests d'IA basés sur le cloud ?

A :Avec Ollama Docker, vous pouvez déployer des modèles d'IA dans le cloud à des fins de test, en contournant le besoin d'une infrastructure GPU locale, ce qui en fait un outil idéal pour les entreprises qui souhaitent évaluer les modèles d'IA de manière évolutive et efficace en termes de ressources.

More information on Ollama Docker

Top 5 Countries

Traffic Sources

Ollama Docker Alternatives

Plus Alternatives-

Exécutez de grands modèles linguistiques localement en utilisant Ollama. Profitez d'une installation facile, d'une personnalisation des modèles et d'une intégration transparente pour le développement de la PNL et des chatbots.

-

Profitez de GPU abordables et puissants pour le développement IA sur Agora Labs. Avec une installation rapide et une interface Jupyter Lab conviviale, peaufinez facilement vos modèles et accélérez vos projets.

-

Le projet LlamaEdge vous permet d'exécuter facilement des applications d'inférence LLM et de créer des services API compatibles avec OpenAI pour la série de LLM Llama2, le tout en local.

-

Axolotl est un outil Open Source qui rend le fin-réglage des modèles d'IA convivial, rapide et ludique – sans compromettre les fonctionnalités ni l'évolutivité.

-

VoltaML Advanced Stable Diffusion WebUI,Facile à utiliser, mais riche en fonctionnalités avec une installation simple. Par la communauté, pour la communauté. VoltaML Advanced Stable Diffusion WebUI, Facile à utiliser, mais riche en fonctionnalités avec une installation simple. Par la communauté, pour la communauté.

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)