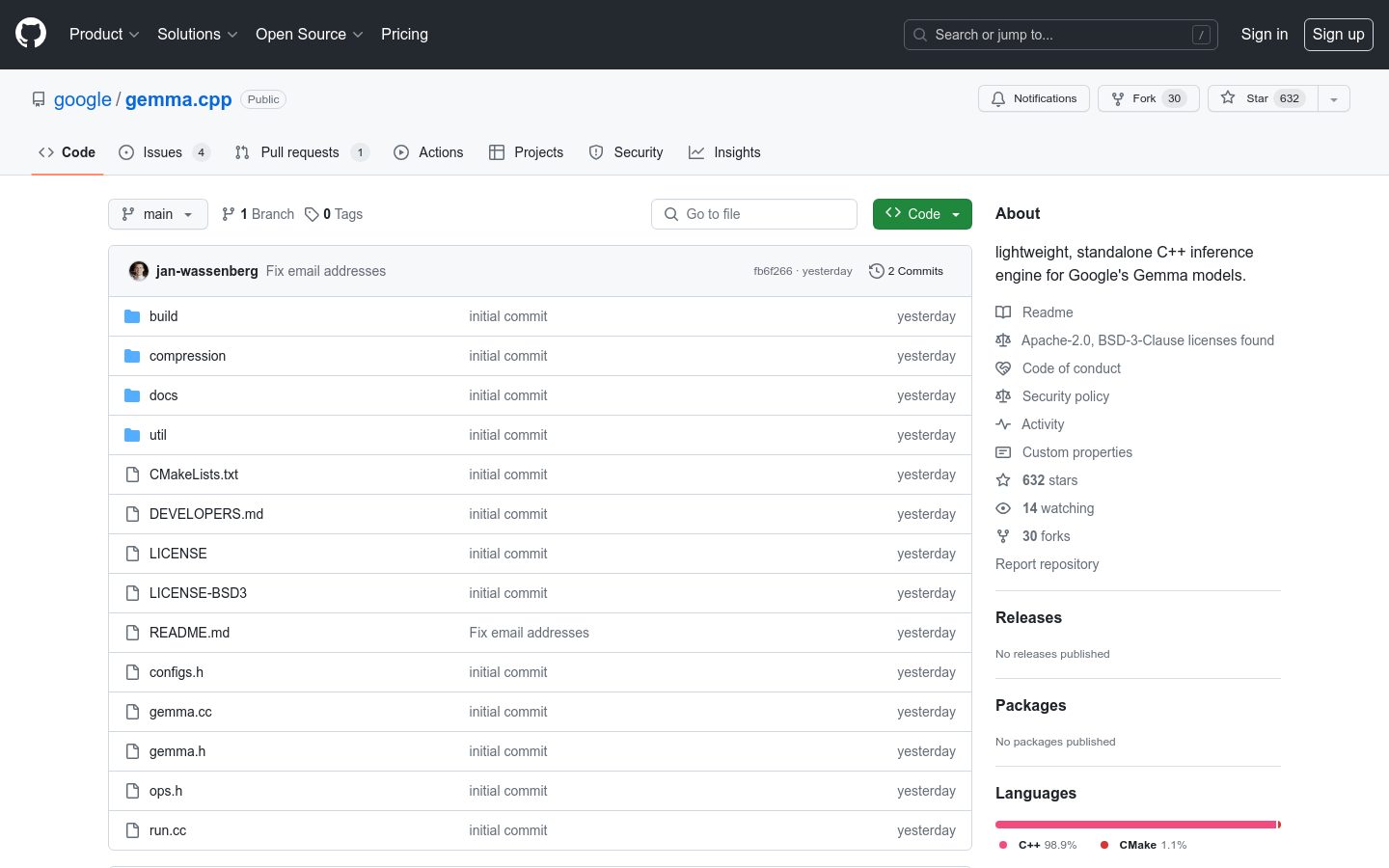

What is gemma.cpp?

gemma.cpp 是一款轻量级独立 C++ 推理引擎,专为 Google 的 Gemma 基础模型而设计。它提供了 Gemma 2B 和 7B 模型的简化实现,优先考虑简单性和直接性。借助 gemma.cpp,研究人员和开发人员可以轻松试验 Gemma 模型并将其嵌入到项目中,同时还可以受益于其最小的依赖项和可移植性。它适用于实验和研究用例,而面向生产的边缘部署更适合 Python 框架,如 JAX、Keras、PyTorch 和 Transformers。

主要特点:

? 最小化实现:gemma.cpp 提供了 Gemma 2B 和 7B 模型的简化实现,专注于简单性和直接性。

? 实验和研究:它专为实验和研究用例而设计,允许用户在其他项目中轻松嵌入它,且依赖项最少。

? 可移植 SIMD:gemma.cpp 利用 Google Highway 库来利用可移植 SIMD 进行 CPU 推断,确保高效且优化的性能。

用例:

研究和实验:gemma.cpp 非常适合想要试验 Gemma 模型并探索新算法的研究人员和开发人员。它为以最少的依赖项测试和修改 Gemma 模型提供了一个简单而直接的平台。

模型嵌入:gemma.cpp 可以轻松嵌入到其他项目中,允许开发人员将 Gemma 模型纳入他们自己的应用程序和系统。这使得利用 Gemma 的能力成为可能,而无需进行广泛的修改或额外的依赖项。

可移植推理:借助 gemma.cpp,用户可以使用可移植 SIMD 执行 CPU 推断,从而确保在不同系统和体系结构中实现高效且优化的性能。这使其适用于对资源效率和性能至关重要的边缘部署。

结论:

gemma.cpp 是一款轻量级独立 C++ 推理引擎,专为 Google 的 Gemma 基础模型而设计。其极简主义的实现专注于简单性和直接性,使其成为希望试验 Gemma 模型的研究人员和开发人员的绝佳选择。借助 gemma.cpp,用户可以轻松地将 Gemma 模型嵌入到他们的项目中,并受益于其最小的依赖项和可移植 SIMD 以进行高效的 CPU 推断。虽然 gemma.cpp 针对实验和研究用例,但建议对面向生产的边缘部署使用 Python 框架。释放 gemma.cpp 的潜力,立即革新您的研究和开发流程!访问 ai.google.dev/gemma 了解更多信息。

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)