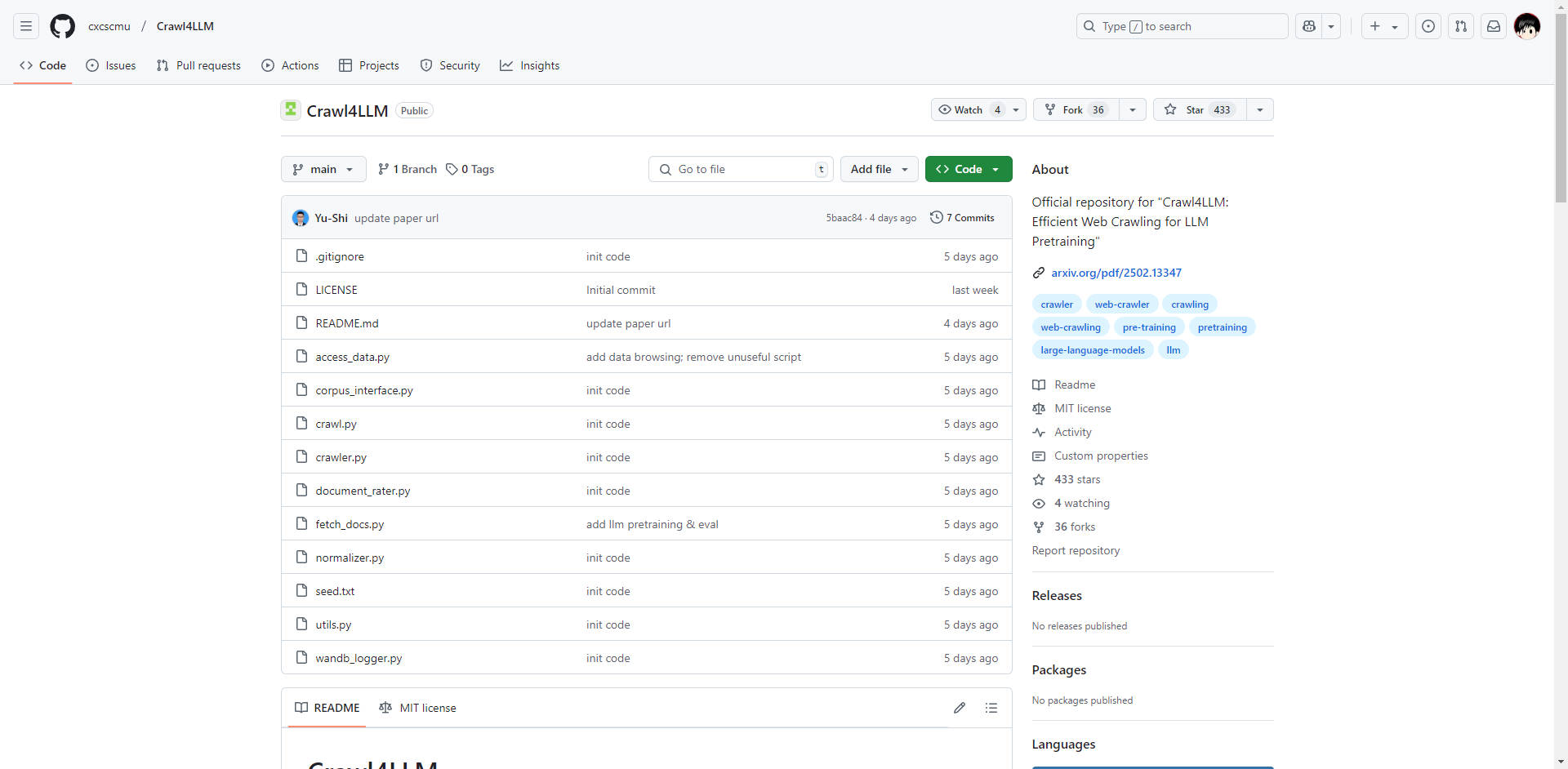

What is Crawl4LLM?

在大語言模型 (LLM) 時代,資料獲取的品質和效率至關重要。傳統的網路爬蟲經常難以應對龐大的網路資料量,導致資源浪費和次優的訓練資料集。清華大學和卡內基梅隆大學合作的開源專案 Crawl4LLM 正是為了應對這一挑戰而生。它是一個智慧型網路爬取系統,旨在優先收集對 LLM 預訓練具有高價值的網頁,從而將資料獲取效率提高近 5 倍。

主要特色:

🤖 智慧型網頁選擇: 採用預先訓練的影響力評分系統(使用 DCLM fastText 模型)在爬取之前評估網頁內容的價值。 這樣可以優先處理高價值頁面,最大限度地減少不相關或低品質資料的收集。技術細節: 評分會考量內容品質、相關性和其他指標,從而對頁面對於 LLM 訓練的有用性進行全面評估。

⚙️ 多種爬取模式: 提供靈活性,以適應各種資料獲取需求:

智慧模式: 根據網頁價值分數動態調整爬取策略。 這是最大化效率的核心模式。

隨機模式: 提供類似於傳統爬蟲的基準爬取方法,適用於不需要目標資料的場景。

基於連結的模式: 根據外向連結的數量對頁面進行優先排序,適用於廣泛的資料收集。

💾 定期爬蟲狀態儲存: 透過定期儲存爬蟲的狀態來支援穩健的爬取。 這樣可以從上次中斷點恢復爬取,防止資料遺失,並確保即使在長時間執行的任務中也能有效運作。

📊 資料瀏覽和視覺化: 包含用於瀏覽爬取資料和視覺化爬取進度和有效性的直觀工具。 這提供了即時監控,並允許立即評估資料品質。

🔗 無縫 DCLM 框架整合: 專為與 DCLM (Deep Learning Model) 預訓練框架直接整合而設計。 這簡化了資料管道,使爬取的資料能夠立即用於 LLM 預訓練,從而最大限度地減少資料傳輸和處理開銷。技術細節: 促進高效的資料流,並降低將爬蟲與訓練過程整合的複雜性。

⚖️ 降低網站負載: 智慧地篩選目標網頁,最大限度地減少網站伺服器上的壓力,並促進合乎道德和規範的爬取實務。

技術架構(簡要概述):

Crawl4LLM 的智慧來自其核心元件:

預先訓練的影響力評分: DCLM fastText 模型用於對網頁內容進行評分。 該模型評估內容品質、相關性和其他因素,以確定頁面對於 LLM 訓練的價值。

優先佇列排程: 優先佇列用於管理爬取過程。 具有較高影響力分數的頁面會被優先處理,確保首先收集最有價值的資料。

多維資料評估: 該系統會考量各種指標,包括內容長度、連結計數和影響力分數,以提供對每個網頁的整體評估。

模擬和最佳化: 廣泛的模擬用於驗證演算法的有效性,並微調參數以獲得最佳的爬取效能。

使用案例:

大規模 LLM 預訓練: 加速為 LLM 建立高品質訓練資料集。 例如,開發新型對話式 AI 模型的研究團隊可以使用 Crawl4LLM 從網路有效收集相關文字資料,從而縮短訓練時間並提高模型效能。

目標資料集建構: 建立專注於特定領域或主題的專業資料集。 建立醫學 LLM 的團隊可以使用 Crawl4LLM 專注於從信譽良好的醫學網站和出版物收集資料,確保資料集與目標領域高度相關。

增強的搜尋引擎索引: 提高用於搜尋引擎索引的資料品質。 透過優先處理高價值頁面,Crawl4LLM 可以幫助搜尋引擎識別和索引最相關且資訊豐富的內容,從而產生更好的搜尋結果。

網路監控和分析: 透過識別有價值的資料,Crawl4LLM 可以有效率地從各種來源收集和分析資訊。

結論:

Crawl4LLM 為 LLM 預訓練的網路爬取提供了顯著的進步。 其智慧型網頁選擇、靈活的爬取模式以及與 DCLM 框架的無縫整合,為尋求建立高品質 LLM 資料集的研究人員和開發人員提供了強大而有效的解決方案。 透過優先考慮資料品質並最大限度地減少資源浪費,Crawl4LLM 使使用者能夠在更短的時間內訓練出更有效的 LLM。

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)