Meilleurs LiveBench alternatives en 2025

-

WildBench est un outil de benchmark avancé qui évalue les LLM sur un ensemble diversifié de tâches du monde réel. Il est essentiel pour ceux qui cherchent à améliorer les performances de l'IA et à comprendre les limites des modèles dans des scénarios pratiques.

-

BenchLLM : Évaluez les réponses des LLM, construisez des suites de tests, automatisez les évaluations. Améliorez les systèmes pilotés par l’IA grâce à des évaluations de performance complètes.

-

Lancez plus rapidement vos produits d'IA grâce aux évaluations LLM sans code. Comparez plus de 180 modèles, concevez des invites et testez en toute confiance.

-

Les entreprises de toutes tailles utilisent Confident AI pour justifier la mise en production de leur LLM.

-

xbench : Le benchmark IA qui mesure l'utilité concrète et les capacités de pointe. Bénéficiez d'une évaluation précise et dynamique des agents d'IA grâce à notre système à double approche.

-

Deepchecks : La plateforme de bout en bout pour l'évaluation des LLM. Testez, comparez et supervisez systématiquement vos applications IA, du développement à la production. Réduisez les hallucinations et accélérez vos déploiements.

-

Braintrust: La plateforme intégrée pour développer, tester et superviser des applications IA fiables. Garantissez des résultats LLM prévisibles et de haute qualité.

-

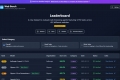

Explorez le Berkeley Function Calling Leaderboard (également appelé Berkeley Tool Calling Leaderboard) pour observer la capacité des LLM à appeler des fonctions (ou outils) avec précision.

-

Le classement Open LLM Leaderboard de Huggingface vise à promouvoir une collaboration ouverte et la transparence dans l'évaluation des modèles de langage.

-

Les données de Klu.ai en temps réel alimentent ce classement pour évaluer les fournisseurs de LLM, permettant la sélection de l'API et du modèle optimaux pour vos besoins.

-

Web Bench est un ensemble de données de référence inédit, ouvert et exhaustif, spécialement conçu pour évaluer les performances des agents IA de navigation web sur des tâches complexes et réelles, à travers un large éventail de sites web actifs.

-

FutureX: Évaluez dynamiquement la puissance prédictive des agents LLM en conditions réelles pour les événements futurs. Obtenez des éclairages purs et impartiaux sur la véritable intelligence de l'IA.

-

BenchX : Évaluez et améliorez les agents d'IA. Suivez les décisions, les logs et les métriques. Intégrez BenchX à l'intégration continue et à la livraison continue (CI/CD). Obtenez des informations exploitables.

-

ZeroBench : Le banc d'essai ultime pour les modèles multimodaux, évaluant le raisonnement visuel, la précision et les compétences computationnelles à travers 100 questions complexes et 334 sous-questions.

-

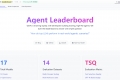

Choisissez l'agent d'IA le plus adapté à vos besoins grâce au Agent Leaderboard : des données de performance impartiales et concrètes, basées sur 14 benchmarks.

-

Évaluez et améliorez vos applications LLM grâce à RagMetrics. Automatisez les tests, mesurez la performance et optimisez les systèmes RAG pour obtenir des résultats fiables.

-

Ne devinez plus votre positionnement en recherche IA. LLMrefs suit les mots-clés dans ChatGPT, Gemini et bien d'autres. Obtenez votre LLMrefs Score et surpassez vos concurrents !

-

Le classement SEAL montre que la famille GPT d'OpenAI occupe la première place dans trois des quatre domaines initiaux utilisés pour classer les modèles d'IA, Claude 3 Opus d'Anthropic PBC s'emparant de la première place dans la quatrième catégorie. Les modèles Gemini de Google LLC ont également bien performé, se classant en tête à égalité avec les modèles GPT dans quelques-uns des domaines.

-

LightEval est une suite d'évaluation d'LLM légère que Hugging Face utilise en interne avec la bibliothèque de traitement de données LLM datatrove récemment publiée et la bibliothèque d'entraînement LLM nanotron.

-

Évaluez facilement les grands modèles linguistiques avec PromptBench. Estimez les performances, améliorez les capacités du modèle et testez la robustesse face aux invites adverses.

-

Unlock robust, vetted answers with the LLM Council. Our AI system uses multiple LLMs & peer review to synthesize deep, unbiased insights for complex queries.

-

Geekbench AI est un outil de référencement d'IA multiplateforme qui utilise des tâches d'apprentissage automatique du monde réel pour évaluer les performances des charges de travail d'IA.

-

Stax : Déployez vos applications LLM en toute confiance. Évaluez les modèles et les prompts d'IA selon vos propres critères pour des analyses éclairées par les données. Développez une IA plus performante, plus rapidement.

-

Comparez instantanément les sorties de ChatGPT, Claude et Gemini côte à côte en utilisant une seule invite. Parfait pour les chercheurs, les créateurs de contenu et les passionnés d'IA, notre plateforme vous aide à choisir le meilleur modèle linguistique pour vos besoins, garantissant des résultats optimaux et une efficacité accrue.

-

Evaligo : Votre plateforme de développement IA tout-en-un. Concevez, testez et supervisez vos prompts de production pour déployer des fonctionnalités IA fiables à grande échelle. Prévenez les régressions coûteuses.

-

Vous avez du mal à déployer des applications LLM fiables ? Parea AI aide les équipes d'IA à évaluer, déboguer et superviser vos systèmes d'IA, du développement à la production. Déployez en toute confiance.

-

Weights & Biases: La plateforme unifiée pour développeurs d'IA, conçue pour accélérer la construction, l'évaluation et la gestion des modèles de ML, des LLM et des agents.

-

Literal AI : Observabilité et évaluation pour RAG et LLMs. Débuggez, surveillez et optimisez les performances, tout en garantissant que vos applications d'IA sont prêtes pour la production.

-

AutoArena est un outil open source qui automatise les évaluations tête-à-tête en utilisant des juges LLM pour classer les systèmes GenAI. Générez rapidement et avec précision des classements comparant différents LLM, configurations RAG ou variations de prompts - Ajustez des juges personnalisés pour répondre à vos besoins.

-

Appelez toutes les API LLM en utilisant le format OpenAI. Utilisez Bedrock, Azure, OpenAI, Cohere, Anthropic, Ollama, Sagemaker, HuggingFace, Replicate (100+ LLM)