2025年最好的 LiveBench 替代方案

-

WildBench 是一個先進的基準測試工具,用於評估 LLM 在各種真實世界任務中的表現。對於那些希望提升 AI 效能並了解模型在實際情境中的局限性的人來說,它是必不可少的工具。

-

BenchLLM:評估大型語言模型 (LLM) 回應,建立測試套件,自動化評估流程。透過全面的效能評估,提升 AI 系統效能。

-

-

-

-

Deepchecks:大型語言模型(LLM)的端對端評估平台。 從開發到上線,有系統地測試、比較並監控您的AI應用程式。 有效降低幻覺,並加速產品上市。

-

-

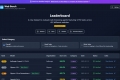

探索柏克萊函數呼叫排行榜(也稱為柏克萊工具呼叫排行榜),了解大型語言模型 (LLM) 準確呼叫函數(又稱工具)的能力。

-

Huggingface 的 Open LLM Leaderboard 目標是促進語言模型評估的開放合作與透明度。

-

即時的 Klu.ai 資料為此排行榜提供動力,用於評估 LLM 供應商,讓您能夠根據自身需求選擇最佳的 API 和模型。

-

Web Bench 是一個嶄新、開放且全面的基準測試資料集,專門設計來評估 AI 網頁瀏覽代理在處理複雜的真實世界任務時,於各式各樣的實際運作網站上的效能表現。

-

-

-

-

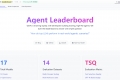

透過 Agent Leaderboard 選擇最符合您需求的 AI 代理程式——此排行榜提供橫跨 14 項基準的公正、真實效能見解。

-

使用 RagMetrics 評估並改善您的 LLM 應用程式。自動化測試、衡量效能,並優化 RAG 系統,以獲得可靠的結果。

-

別再猜測您的 AI 搜尋排名了。LLMrefs 能追蹤 ChatGPT、Gemini 等平台的關鍵字。取得您的 LLMrefs 分數,並在排名上超越競爭對手!

-

SEAL 排行榜顯示,OpenAI 的 GPT 系列大型語言模型 (LLM) 在用於評估 AI 模型的四個初始領域中的三個領域中排名第一,Anthropic PBC 的熱門 Claude 3 Opus 在第四個類別中奪得第一。Google LLC 的 Gemini 模型也表現出色,在幾個領域中與 GPT 模型並列第一。

-

LightEval 是一個輕量級的 LLM 評估套件,Hugging Face 在內部一直使用它,搭配最近發佈的 LLM 資料處理函式庫 datatrove 和 LLM 訓練函式庫 nanotron。

-

-

Unlock robust, vetted answers with the LLM Council. Our AI system uses multiple LLMs & peer review to synthesize deep, unbiased insights for complex queries.

-

Geekbench AI 是一個跨平台的 AI 基準測試工具,它使用真實世界的機器學習任務來評估 AI 工作負載效能。

-

-

使用單一提示,立即並排比較 ChatGPT、Claude 和 Gemini 的輸出。我們的平台非常適合研究人員、內容創作者和 AI 愛好者,可幫助您根據自身需求選擇最佳語言模型,確保最佳結果和效率。

-

-

為推出可靠的 LLM 應用程式而苦惱嗎?Parea AI 協助 AI 團隊,從開發到正式上線,全面評估、偵錯與監控您的 AI 系統。助您安心部署,信心滿載。

-

Weights & Biases:整合式人工智慧開發平台,助您更快打造、評估與管理機器學習、大型語言模型與代理程式。

-

Literal AI:針對 RAG 與 LLM 的可觀測性與評估。除錯、監控、最佳化效能並確保 AI 應用程式已準備好上線。

-

AutoArena 是一個開源工具,它使用 LLM 評審自動執行頭對頭評估,以對 GenAI 系統進行排名。快速準確地生成排行榜,比較不同的 LLM、RAG 設置或提示變異——微調自定義評審以滿足您的需求。

-

使用 OpenAI 格式呼叫所有 LLM API。使用 Bedrock、Azure、OpenAI、Cohere、Anthropic、Ollama、Sagemaker、HuggingFace、Replicate(100 多個 LLM)