What is Huggingface's Open LLM Leaderboard?

Le tableau de bord Open LLM de Huggingface présente une série d'améliorations par rapport à son prédécesseur, qui a déjà servi de plaque tournante essentielle pour plus de 2 millions de visiteurs. Il offre désormais des points de référence plus stimulants, un processus d'évaluation affiné et une meilleure expérience utilisateur. L'objectif principal du tableau de bord est de distiller le véritable potentiel des LLM en surmontant les limites des points de référence existants, tels que la facilité et la contamination des données, garantissant que les performances des modèles reflètent de véritables progrès plutôt que des métriques optimisées.

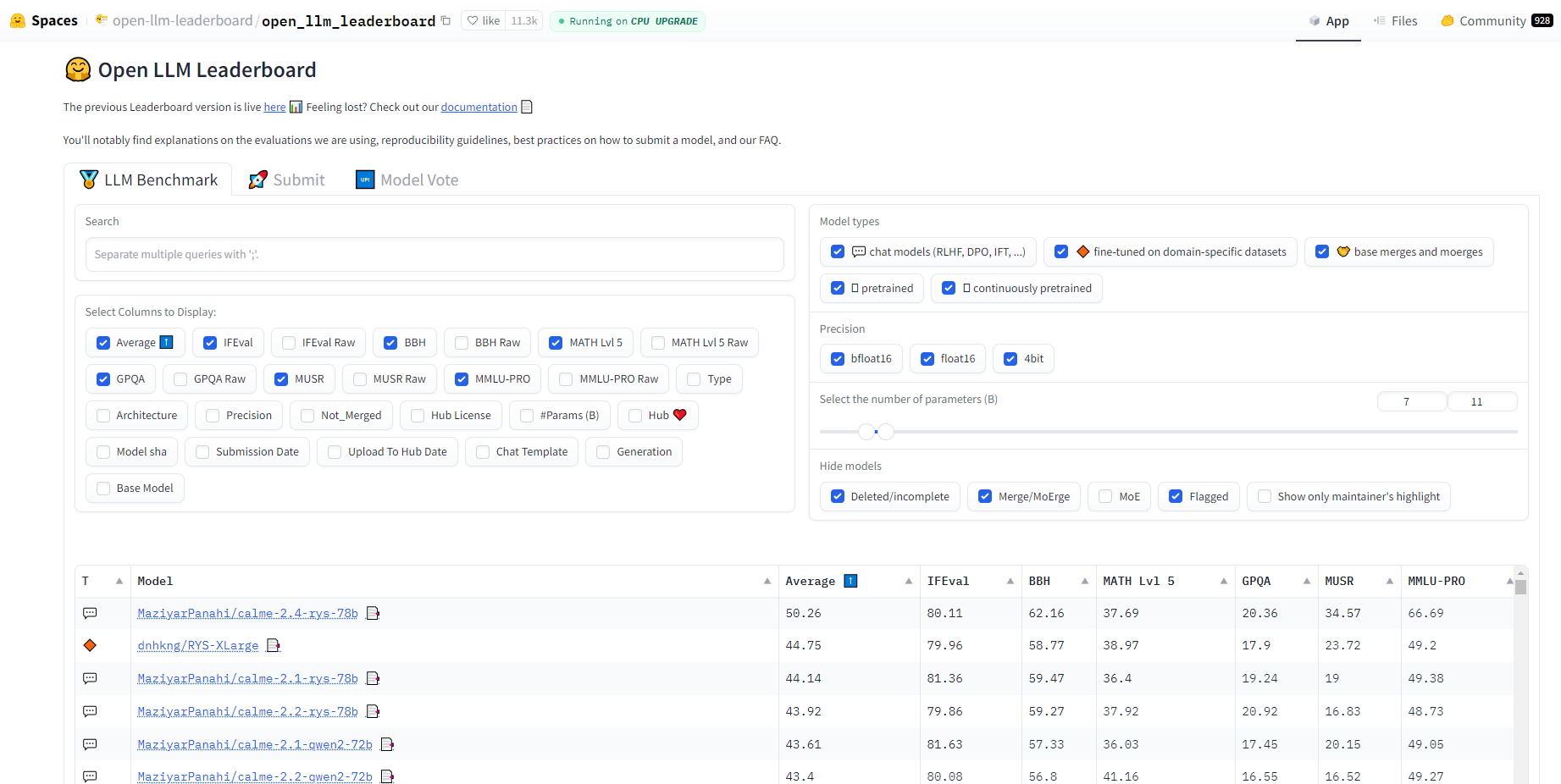

Fonctionnalités clés

Nouveaux points de référence : Six points de référence rigoureux sont introduits pour tester une gamme de compétences allant de la connaissance et du raisonnement aux mathématiques complexes et au suivi d'instructions.

Notation standardisée : Un nouveau système de notation qui standardise les résultats pour tenir compte des niveaux de difficulté variables entre les différents points de référence.

Harnais d'évaluation mis à jour : Collaboration avec EleutherAI pour un harnais mis à jour afin de garantir que les évaluations restent cohérentes et reproductibles.

Recommandations des mainteneurs : Une liste organisée des modèles les plus performants provenant de diverses sources, offrant un point de départ fiable pour les utilisateurs.

Vote de la communauté : Un système de vote permettant à la communauté de prioriser les modèles pour l'évaluation, garantissant que les modèles les plus attendus soient évalués rapidement.

Cas d'utilisation

Recherche et développement : Les chercheurs peuvent identifier les modèles les plus prometteurs pour un développement ou une personnalisation supplémentaires en fonction de métriques de performance détaillées.

Implémentation commerciale : Les entreprises qui cherchent à intégrer des LLM dans leurs produits peuvent sélectionner des modèles qui excellent dans des tâches et des domaines pertinents.

Objectifs éducatifs : Les éducateurs et les étudiants peuvent utiliser le tableau de bord pour comprendre l'état actuel des capacités des LLM et la progression du domaine.

Conclusion

Le tableau de bord Open LLM de Huggingface n'est pas qu'une mise à jour ; c'est une avancée significative dans l'évaluation des LLM. En offrant une évaluation plus précise, plus stimulante et pilotée par la communauté, il ouvre la voie à la prochaine génération de modèles de langage. Explorez le tableau de bord, contribuez vos modèles et participez à façonner l'avenir de l'IA.

More information on Huggingface's Open LLM Leaderboard

Huggingface's Open LLM Leaderboard Alternatives

Plus Alternatives-

Les données de Klu.ai en temps réel alimentent ce classement pour évaluer les fournisseurs de LLM, permettant la sélection de l'API et du modèle optimaux pour vos besoins.

-

Explorez le Berkeley Function Calling Leaderboard (également appelé Berkeley Tool Calling Leaderboard) pour observer la capacité des LLM à appeler des fonctions (ou outils) avec précision.

-

-

Découvrez, comparez et classez les modèles de langage volumineux sans effort avec LLM Extractum. Simplifiez votre processus de sélection et favorisez l'innovation dans les applications d'IA.

-