What is LlamaEdge?

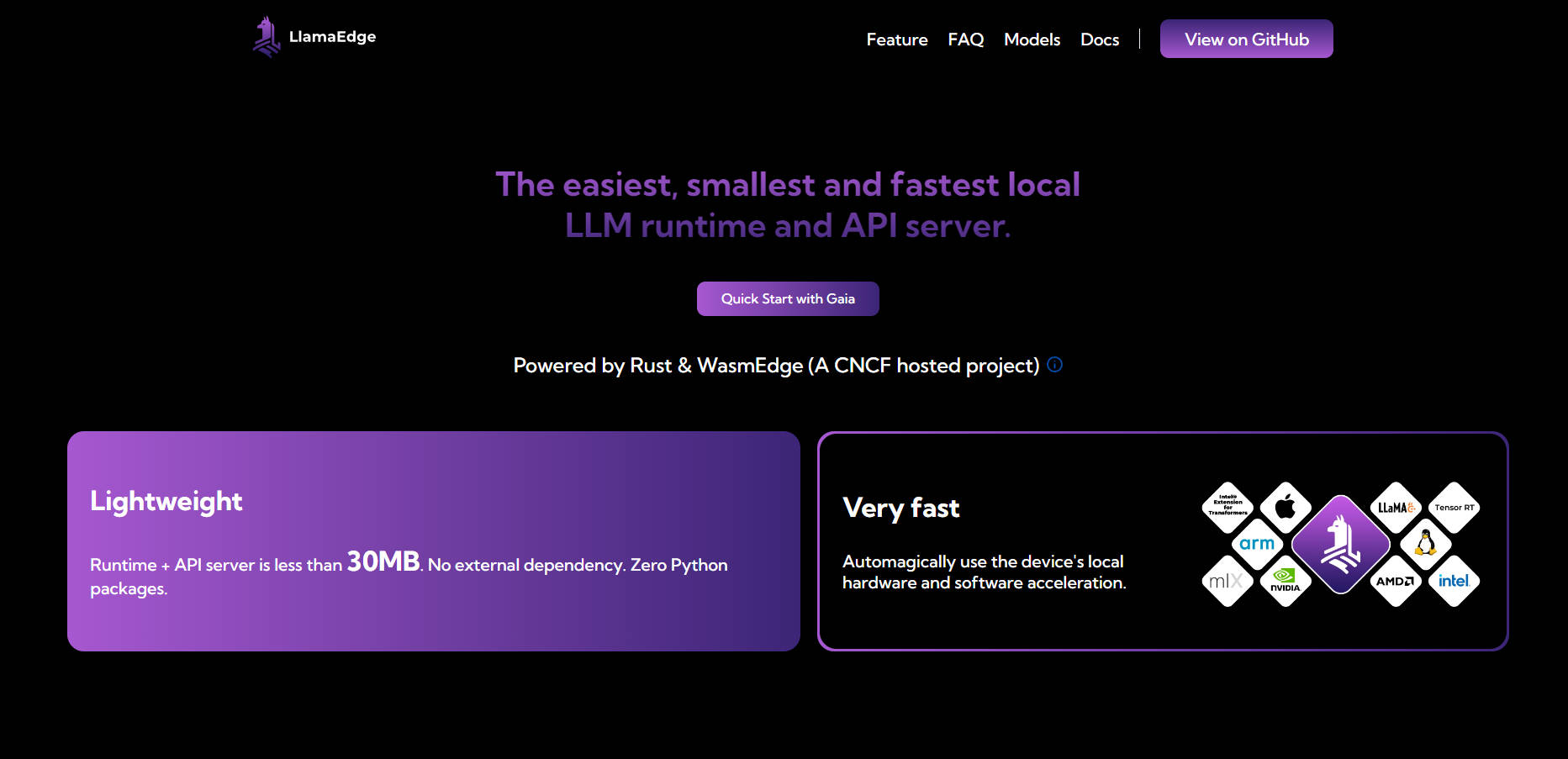

Imaginez avoir la capacité d'exécuter et d'affiner des grands modèles de langage (LLM) directement sur votre appareil, sans le cloud, sans complexité et sans compromettre les performances. C'est exactement ce que LlamaEdge vous offre. Que vous soyez un développeur créant des applications basées sur l'IA ou une entreprise cherchant à déployer des LLM privés et personnalisés, LlamaEdge est la solution légère, rapide et portable que vous attendiez.

Avec un runtime de moins de 30 Mo et zéro dépendance, LlamaEdge est conçu pour simplifier le processus d'exécution des LLM en local ou en périphérie. Il est conçu pour tirer pleinement parti du matériel de votre appareil, garantissant des vitesses natives et un déploiement multiplateforme transparent.

Fonctionnalités clés

💡 Exécutez les LLM en local ou en périphérie

Déployez et affinez les LLM directement sur votre appareil, assurant la confidentialité des données et éliminant la dépendance à des services cloud coûteux.

🌐 Compatibilité multiplateforme

Écrivez votre code une seule fois et déployez-le n'importe où, que ce soit sur un MacBook, un GPU NVIDIA ou un appareil périphérique. Pas besoin de reconstruire ou de tester à nouveau pour différentes plateformes.

⚡ Léger et rapide

Avec un runtime inférieur à 30 Mo et aucune dépendance externe, LlamaEdge est incroyablement léger. Il exploite automatiquement l'accélération matérielle de votre appareil pour des performances optimales.

🛠️ Conception modulaire pour la personnalisation

Assemblez vos agents et applications LLM comme des blocs Lego en utilisant Rust ou JavaScript. Créez des binaires compacts et autonomes qui s'exécutent de manière transparente sur tous les appareils.

🔒 Confidentialité et sécurité améliorées

Gardez vos données locales et sécurisées. LlamaEdge s'exécute dans un environnement sandboxé, ne nécessite aucune autorisation root et garantit que vos interactions restent privées.

Cas d'utilisation

Création d'assistants IA privés

Créez des chatbots ou des assistants virtuels basés sur l'IA qui s'exécutent entièrement sur votre appareil, protégeant les données sensibles tout en offrant des interactions rapides et réactives.Développement d'applications LLM personnalisées

Ajustez les LLM pour des secteurs ou des cas d'utilisation spécifiques, qu'il s'agisse de l'analyse de documents juridiques, du support client ou des diagnostics de santé, sans avoir besoin de solutions basées sur le cloud.Déploiement de l'IA sur des appareils périphériques

Apportez des capacités d'IA aux appareils périphériques tels que les capteurs IoT ou les applications mobiles, permettant une prise de décision en temps réel sans latence ni problèmes de connectivité.

Pourquoi choisir LlamaEdge ?

Rentable : Évitez les coûts élevés des API LLM hébergées et la complexité de la gestion de l'infrastructure cloud.

Personnalisable : Adaptez les LLM à vos besoins spécifiques sans les limitations des modèles à usage général.

Portable : Déployez vos applications sur différentes plateformes et appareils avec un seul fichier binaire.

Pérenne : Gardez une longueur d'avance grâce à la prise en charge des modèles multimodaux, des runtimes alternatifs et des technologies d'IA émergentes.

FAQ

Q : Comment LlamaEdge se compare-t-il aux solutions basées sur Python ?

R : Les solutions basées sur Python comme PyTorch sont livrées avec de grandes dépendances et sont plus lentes pour l'inférence au niveau de la production. LlamaEdge, en revanche, est léger (moins de 30 Mo), plus rapide et exempt de conflits de dépendances.

Q : LlamaEdge est-il compatible avec les GPU et les accélérateurs matériels ?

R : Absolument. LlamaEdge exploite automatiquement l'accélération matérielle de votre appareil, garantissant des vitesses natives sur les CPU, les GPU et les NPU.

Q : Puis-je utiliser LlamaEdge avec des modèles open source existants ?

R : Oui. LlamaEdge prend en charge un large éventail de modèles AI/LLM, y compris toute la série Llama2, et vous permet de les affiner pour vos besoins spécifiques.

Q : Qu'est-ce qui rend LlamaEdge plus sécurisé que les autres solutions ?

R : LlamaEdge s'exécute dans un environnement sandboxé, ne nécessite aucune autorisation root et garantit que vos données ne quittent jamais votre appareil, ce qui en fait un choix plus sûr pour les applications sensibles.

Prêt à commencer ?

Avec LlamaEdge, l'exécution et l'affinage des LLM en local n'ont jamais été aussi simples. Que vous créiez des applications basées sur l'IA ou que vous déployiez des modèles sur des appareils périphériques, LlamaEdge vous permet d'en faire plus, avec moins. Installez-le dès aujourd'hui et découvrez l'avenir du déploiement local de LLM.

More information on LlamaEdge

Top 5 Countries

Traffic Sources

LlamaEdge Alternatives

Plus Alternatives-

La manière la plus simple et la plus détendue de construire des applications de LLM multi-agents.

-

Découvrez Code Llama, un outil d'IA de pointe pour la génération et la compréhension de code. Améliorez votre productivité, rationalisez les flux de travail et donnez du pouvoir aux développeurs.

-

Llamafile est un projet réalisé par une équipe de Mozilla. Il permet aux utilisateurs de distribuer et d'exécuter des LLM à l'aide d'un seul fichier indépendant de la plateforme.

-

WordLlama est un utilitaire de traitement du langage naturel (TLN) qui recycle des composants de grands modèles de langage (LLM) pour créer des représentations de mots efficaces et compactes, similaires à GloVe, Word2Vec ou FastText.

-

Engagez-vous dans des conversations avec des modèles d'IA tels qu'Alpaca et LLaMa. Intégration ChatGPT, exécution locale, et plus encore. Essayez LlamaChat dès maintenant !

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)