What is LlamaEdge?

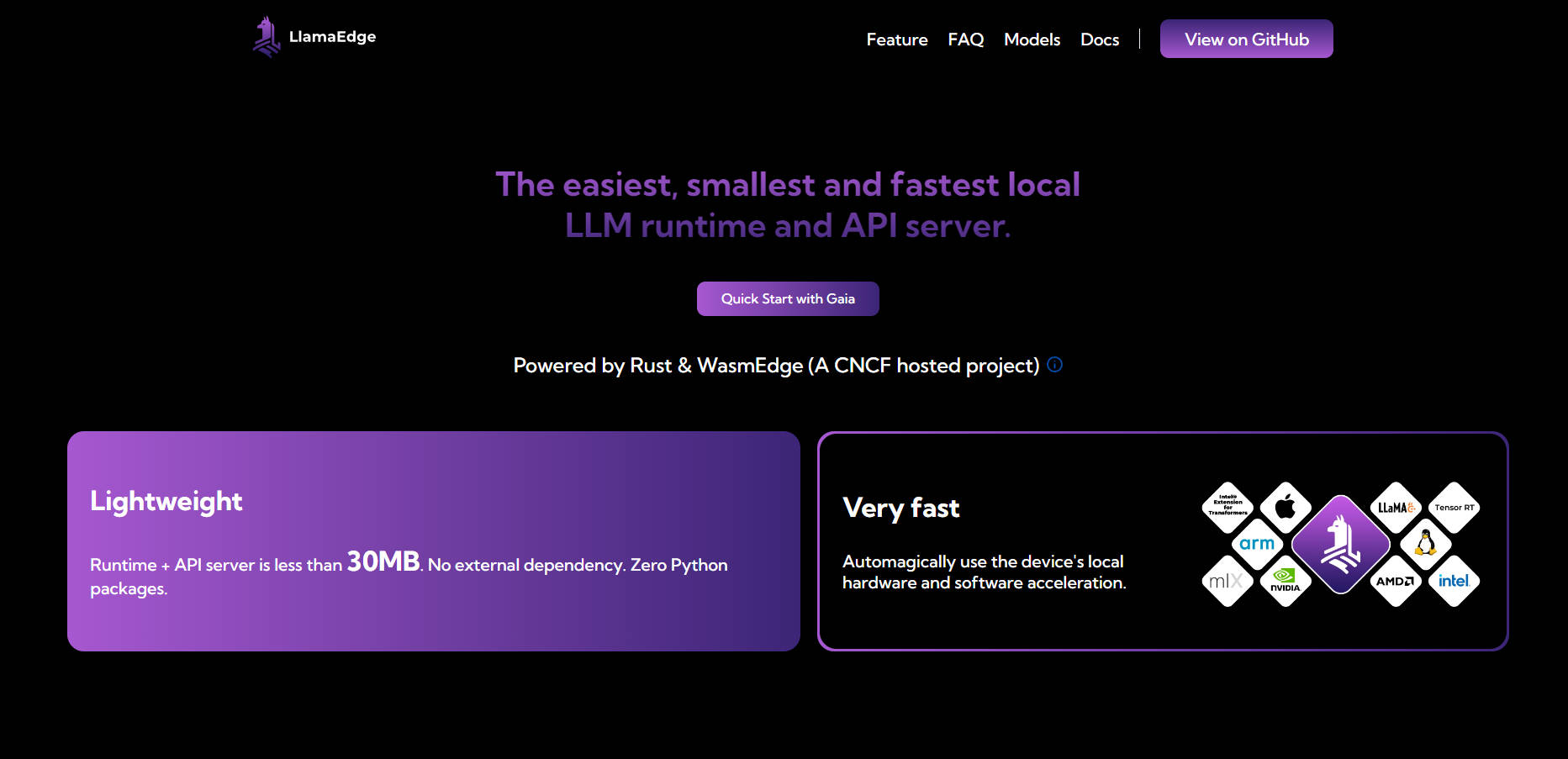

想象一下,你能够直接在设备上运行和微调大型语言模型(LLM),无需依赖云端,无需复杂的设置,也无需牺牲性能——这正是 LlamaEdge 所提供的强大功能。无论你是构建 AI 驱动应用的开发者,还是寻求部署私有化、定制化 LLM 的企业,LlamaEdge 都是你翘首以盼的轻量级、快速且便携的解决方案。

LlamaEdge 运行时小于 30MB,且零依赖,旨在简化在本地或边缘运行 LLM 的流程。它充分利用设备的硬件资源,确保原生速度和无缝的跨平台部署。

主要特性

💡 在本地或边缘运行 LLM

直接在你的设备上部署和微调 LLM,确保数据隐私,并摆脱对昂贵云服务的依赖。

🌐 跨平台兼容性

一次编写代码,即可在任何地方部署——无论是 MacBook、NVIDIA GPU 还是边缘设备。无需为不同的平台重建或重新测试。

⚡ 轻量且快速

LlamaEdge 运行时小于 30MB,且没有外部依赖,非常轻巧。它能够自动利用设备的硬件加速功能,以获得最佳性能。

🛠️ 模块化设计,便于定制

像乐高积木一样,使用 Rust 或 JavaScript 组装你的 LLM 代理和应用程序。创建紧凑、自包含的二进制文件,可以在各种设备上无缝运行。

🔒 增强的隐私和安全性

将你的数据保存在本地,确保安全。LlamaEdge 在沙盒环境中运行,无需 root 权限,并确保你的交互保持私密性。

应用场景

构建私有 AI 助手

创建完全在你的设备上运行的 AI 驱动的聊天机器人或虚拟助手,在保护敏感数据的同时,提供快速、响应式的交互。开发定制化的 LLM 应用

针对特定行业或用例微调 LLM——无论是法律文档分析、客户支持还是医疗诊断——而无需基于云的解决方案。在边缘设备上部署 AI

将 AI 功能带到 IoT 传感器或移动应用等边缘设备,实现实时的决策,而无需担心延迟或连接问题。

为什么选择 LlamaEdge?

经济高效: 避免托管 LLM API 的高昂成本以及管理云基础设施的复杂性。

可定制: 根据你的特定需求定制 LLM,而无需受通用模型的限制。

便携: 使用单个二进制文件,在不同的平台和设备上部署你的应用程序。

面向未来: 保持领先,支持多模态模型、替代运行时和新兴 AI 技术。

常见问题解答

问:LlamaEdge 与基于 Python 的解决方案相比如何?

答:像 PyTorch 这样基于 Python 的解决方案带有庞大的依赖项,并且在生产级别的推理中速度较慢。另一方面,LlamaEdge 轻量级(小于 30MB)、速度更快,并且没有依赖冲突。

问:LlamaEdge 与 GPU 和硬件加速器兼容吗?

答:当然。LlamaEdge 能够自动利用设备的硬件加速功能,确保在 CPU、GPU 和 NPU 上实现原生速度。

问:我可以将 LlamaEdge 与现有的开源模型一起使用吗?

答:可以。LlamaEdge 支持各种 AI/LLM 模型,包括整个 Llama2 系列,并允许你针对特定需求进行微调。

问:是什么让 LlamaEdge 比其他解决方案更安全?

答:LlamaEdge 在沙盒环境中运行,无需 root 权限,并确保你的数据永远不会离开你的设备,这使其成为敏感应用更安全的选择。

准备好开始了吗?

有了 LlamaEdge,在本地运行和微调 LLM 从未如此简单。无论你是构建 AI 驱动的应用程序,还是在边缘设备上部署模型,LlamaEdge 都能让你事半功倍。立即安装,体验本地 LLM 部署的未来。

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)