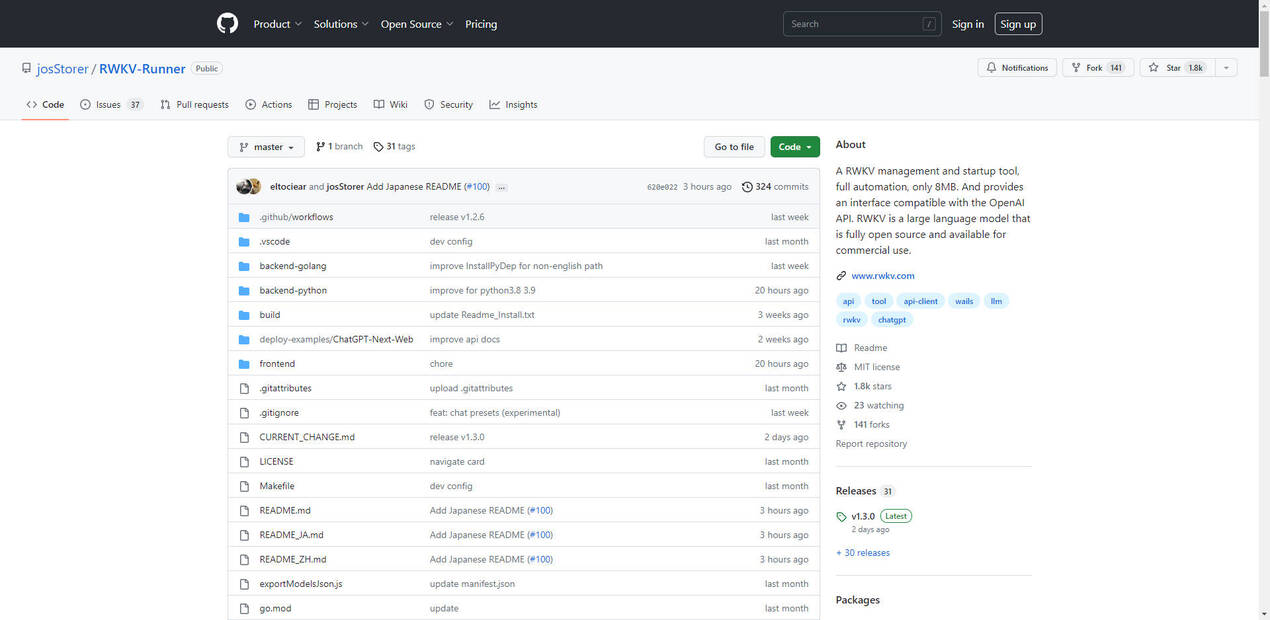

What is RWKV-Runner?

La herramienta RWKV Management and Startup Tool es una solución ligera y totalmente automatizada diseñada para simplificar la implementación y operación del modelo de lenguaje RWKV. Con solo 8 MB, esta herramienta ofrece una integración perfecta con la API de OpenAI, convirtiéndola en una opción ideal para desarrolladores y empresas que buscan una alternativa rentable y de alto rendimiento a los modelos de transformadores tradicionales. RWKV combina las fortalezas de las RNN y los transformadores, ofreciendo inferencia rápida, bajo consumo de recursos y escalabilidad en cualquier longitud de contexto. Totalmente de código abierto y disponible comercialmente, RWKV cuenta con el respaldo de una vibrante comunidad y de la Fundación Linux.

Características principales:

?️ Ligera y eficiente

Con solo 8 MB, la herramienta garantiza un consumo mínimo de recursos manteniendo un alto rendimiento, lo que la hace adecuada para dispositivos con capacidades de hardware limitadas.? Compatibilidad con la API de OpenAI

La herramienta proporciona una interfaz que se integra perfectamente con la API de OpenAI, permitiendo a los usuarios aprovechar las capacidades de RWKV sin reescribir los flujos de trabajo existentes.⚡ Inferencia y entrenamiento rápidos

La arquitectura de RWKV combina la velocidad de las RNN con el rendimiento de los transformadores, ofreciendo entre 10 y 100 veces menos requisitos de cómputo en comparación con los modelos tradicionales.? Longitud de contexto escalable

A diferencia de los transformadores, RWKV escala linealmente con la longitud del contexto, lo que le permite manejar contenido de formato largo sin degradación del rendimiento.? Código abierto y uso comercial permitido

Con licencia Apache 2.0, RWKV es gratuito para uso personal y comercial, respaldado por un modelo de desarrollo impulsado por la comunidad.

Casos de uso:

Chatbots con IA

Los desarrolladores pueden usar RWKV para construir chatbots con tiempos de respuesta rápidos y bajo consumo de recursos, ideales para atención al cliente o aplicaciones interactivas.Generación de contenido multilingüe

El sólido rendimiento de RWKV en idiomas como el chino y el japonés lo convierte en una herramienta valiosa para crear contenido localizado o traducir documentos.Investigación y experimentación

Los investigadores pueden aprovechar la naturaleza de código abierto y los bajos requisitos de cómputo de RWKV para experimentar con modelos de lenguaje personalizados o ajustar modelos existentes para tareas específicas.

Conclusión:

La herramienta RWKV Management and Startup Tool es un cambio de juego para los desarrolladores y empresas que buscan aprovechar el poder de los grandes modelos de lenguaje sin las grandes demandas de recursos de los transformadores tradicionales. Su diseño ligero, la compatibilidad con la API de OpenAI y la licencia de código abierto la convierten en una solución versátil y rentable para una amplia gama de aplicaciones. Ya sea que esté creando chatbots, generando contenido multilingüe o realizando investigaciones, RWKV ofrece el rendimiento y la flexibilidad que necesita.

More information on RWKV-Runner

-

Buggy at times, but overall performs well

-

Could have more documentation for beginners

-

Saves a lot of time for language model tasks

-

Limited features compared to similar software

-

Easy to install and setup, highly recommended

-

Not as intuitive as expected, but still useful

-

Efficient tool for automating language models

-

Great software, very user-friendly interface

RWKV-Runner Alternativas

Más Alternativas-

ChatRWKV es similar a ChatGPT pero funciona con el modelo de lenguaje RWKV (100 % RNN) y es de código abierto.

-

RWKV es una RNN con rendimiento LLM a nivel de transformer. Se puede entrenar directamente como un GPT (paralizable). Por lo tanto, combina lo mejor de RNN y transformer: gran rendimiento, inferencia rápida, ahorra VRAM, entrenamiento rápido, ctx_len "infinito" e incrustación de oraciones gratuita.

-

KTransformers, un proyecto de código abierto del equipo KVCache.AI de Tsinghua y QuJing Tech, optimiza la inferencia de modelos de lenguaje grandes. Reduce los umbrales de hardware, ejecuta modelos de 671B parámetros en GPUs individuales de 24GB de VRAM, aumenta la velocidad de inferencia (hasta 286 tokens/s en pre-procesamiento, 14 tokens/s en generación) y es adecuado para uso personal, empresarial y académico.

-

Max KB es un potente sistema de pregunta y respuesta de base de conocimiento basado en el modelo de lenguaje LLM. Ofrece una integración perfecta y es compatible con varios modelos para una experiencia interactiva mejorada.

-

Descubre Keywords AI, una solución rentable para modelos de IA de alta calidad. Con tecnología LLM basada en GPT-4, optimiza las consultas y reduce costos sin sacrificar el rendimiento. La velocidad de respuesta rápida y la latencia cero garantizan resultados eficientes para la generación de contenido, la traducción de idiomas y el análisis de datos. Elige entre tres planes de suscripción y comienza con el Plan Starter para pruebas iniciales. Sin cargos ocultos. Reserva una demostración o ponte en contacto con el soporte técnico para obtener ayuda.

![[dangao] [dangao]](/static/assets/comment/emotions/dangao.gif)

![[qiu] [qiu]](/static/assets/comment/emotions/qiu.gif)

![[fadou] [fadou]](/static/assets/comment/emotions/fadou.gif)

![[tiaopi] [tiaopi]](/static/assets/comment/emotions/tiaopi.gif)

![[fadai] [fadai]](/static/assets/comment/emotions/fadai.gif)

![[xinsui] [xinsui]](/static/assets/comment/emotions/xinsui.gif)

![[ruo] [ruo]](/static/assets/comment/emotions/ruo.gif)

![[jingkong] [jingkong]](/static/assets/comment/emotions/jingkong.gif)

![[quantou] [quantou]](/static/assets/comment/emotions/quantou.gif)

![[gangga] [gangga]](/static/assets/comment/emotions/gangga.gif)

![[da] [da]](/static/assets/comment/emotions/da.gif)

![[touxiao] [touxiao]](/static/assets/comment/emotions/touxiao.gif)

![[ciya] [ciya]](/static/assets/comment/emotions/ciya.gif)

![[liulei] [liulei]](/static/assets/comment/emotions/liulei.gif)

![[fendou] [fendou]](/static/assets/comment/emotions/fendou.gif)

![[kiss] [kiss]](/static/assets/comment/emotions/kiss.gif)

![[aoman] [aoman]](/static/assets/comment/emotions/aoman.gif)

![[kulou] [kulou]](/static/assets/comment/emotions/kulou.gif)

![[yueliang] [yueliang]](/static/assets/comment/emotions/yueliang.gif)

![[lenghan] [lenghan]](/static/assets/comment/emotions/lenghan.gif)

![[kun] [kun]](/static/assets/comment/emotions/kun.gif)

![[meng] [meng]](/static/assets/comment/emotions/meng.gif)

![[shenma] [shenma]](/static/assets/comment/emotions/shenma.gif)

![[peifu] [peifu]](/static/assets/comment/emotions/peifu.gif)

![[qinqin] [qinqin]](/static/assets/comment/emotions/qinqin.gif)

![[nanguo] [nanguo]](/static/assets/comment/emotions/nanguo.gif)

![[hufen] [hufen]](/static/assets/comment/emotions/hufen.gif)

![[shuai] [shuai]](/static/assets/comment/emotions/shuai.gif)

![[jingya] [jingya]](/static/assets/comment/emotions/jingya.gif)

![[cahan] [cahan]](/static/assets/comment/emotions/cahan.gif)

![[shengli] [shengli]](/static/assets/comment/emotions/shengli.gif)

![[qioudale] [qioudale]](/static/assets/comment/emotions/qioudale.gif)

![[cheer] [cheer]](/static/assets/comment/emotions/cheer.gif)

![[ketou] [ketou]](/static/assets/comment/emotions/ketou.gif)

![[shandian] [shandian]](/static/assets/comment/emotions/shandian.gif)

![[haqian] [haqian]](/static/assets/comment/emotions/haqian.gif)

![[jidong] [jidong]](/static/assets/comment/emotions/jidong.gif)

![[zaijian] [zaijian]](/static/assets/comment/emotions/zaijian.gif)

![[kafei] [kafei]](/static/assets/comment/emotions/kafei.gif)

![[love] [love]](/static/assets/comment/emotions/love.gif)

![[pizui] [pizui]](/static/assets/comment/emotions/pizui.gif)

![[huitou] [huitou]](/static/assets/comment/emotions/huitou.gif)

![[tiao] [tiao]](/static/assets/comment/emotions/tiao.gif)

![[liwu] [liwu]](/static/assets/comment/emotions/liwu.gif)

![[zhutou] [zhutou]](/static/assets/comment/emotions/zhutou.gif)

![[e] [e]](/static/assets/comment/emotions/e.gif)

![[qiang] [qiang]](/static/assets/comment/emotions/qiang.gif)

![[youtaiji] [youtaiji]](/static/assets/comment/emotions/youtaiji.gif)

![[zuohengheng] [zuohengheng]](/static/assets/comment/emotions/zuohengheng.gif)

![[huaixiao] [huaixiao]](/static/assets/comment/emotions/huaixiao.gif)

![[gouyin] [gouyin]](/static/assets/comment/emotions/gouyin.gif)

![[keai] [keai]](/static/assets/comment/emotions/keai.gif)

![[tiaosheng] [tiaosheng]](/static/assets/comment/emotions/tiaosheng.gif)

![[daku] [daku]](/static/assets/comment/emotions/daku.gif)

![[weiqu] [weiqu]](/static/assets/comment/emotions/weiqu.gif)

![[lanqiu] [lanqiu]](/static/assets/comment/emotions/lanqiu.gif)

![[zhemo] [zhemo]](/static/assets/comment/emotions/zhemo.gif)

![[xia] [xia]](/static/assets/comment/emotions/xia.gif)

![[fan] [fan]](/static/assets/comment/emotions/fan.gif)

![[yun] [yun]](/static/assets/comment/emotions/yun.gif)

![[youhengheng] [youhengheng]](/static/assets/comment/emotions/youhengheng.gif)

![[chong] [chong]](/static/assets/comment/emotions/chong.gif)

![[pijiu] [pijiu]](/static/assets/comment/emotions/pijiu.gif)

![[dajiao] [dajiao]](/static/assets/comment/emotions/dajiao.gif)

![[dao] [dao]](/static/assets/comment/emotions/dao.gif)

![[diaoxie] [diaoxie]](/static/assets/comment/emotions/diaoxie.gif)

![[liuhan] [liuhan]](/static/assets/comment/emotions/liuhan.gif)

![[haha] [haha]](/static/assets/comment/emotions/haha.gif)

![[xu] [xu]](/static/assets/comment/emotions/xu.gif)

![[zhuakuang] [zhuakuang]](/static/assets/comment/emotions/zhuakuang.gif)

![[zhuanquan] [zhuanquan]](/static/assets/comment/emotions/zhuanquan.gif)

![[no] [no]](/static/assets/comment/emotions/no.gif)

![[ok] [ok]](/static/assets/comment/emotions/ok.gif)

![[feiwen] [feiwen]](/static/assets/comment/emotions/feiwen.gif)

![[taiyang] [taiyang]](/static/assets/comment/emotions/taiyang.gif)

![[woshou] [woshou]](/static/assets/comment/emotions/woshou.gif)

![[zuqiu] [zuqiu]](/static/assets/comment/emotions/zuqiu.gif)

![[xigua] [xigua]](/static/assets/comment/emotions/xigua.gif)

![[hua] [hua]](/static/assets/comment/emotions/hua.gif)

![[tu] [tu]](/static/assets/comment/emotions/tu.gif)

![[tiaowu] [tiaowu]](/static/assets/comment/emotions/tiaowu.gif)

![[ma] [ma]](/static/assets/comment/emotions/ma.gif)

![[baiyan] [baiyan]](/static/assets/comment/emotions/baiyan.gif)

![[zhadan] [zhadan]](/static/assets/comment/emotions/zhadan.gif)

![[weixiao] [weixiao]](/static/assets/comment/emotions/weixiao.gif)

![[wen] [wen]](/static/assets/comment/emotions/wen.gif)

![[dabing] [dabing]](/static/assets/comment/emotions/dabing.gif)

![[xianwen] [xianwen]](/static/assets/comment/emotions/xianwen.gif)

![[shuijiao] [shuijiao]](/static/assets/comment/emotions/shuijiao.gif)

![[yongbao] [yongbao]](/static/assets/comment/emotions/yongbao.gif)

![[kelian] [kelian]](/static/assets/comment/emotions/kelian.gif)

![[pingpang] [pingpang]](/static/assets/comment/emotions/pingpang.gif)

![[danu] [danu]](/static/assets/comment/emotions/danu.gif)

![[geili] [geili]](/static/assets/comment/emotions/geili.gif)

![[wabi] [wabi]](/static/assets/comment/emotions/wabi.gif)

![[kuaikule] [kuaikule]](/static/assets/comment/emotions/kuaikule.gif)

![[zuotaiji] [zuotaiji]](/static/assets/comment/emotions/zuotaiji.gif)

![[tuzi] [tuzi]](/static/assets/comment/emotions/tuzi.gif)

![[bishi] [bishi]](/static/assets/comment/emotions/bishi.gif)

![[caidao] [caidao]](/static/assets/comment/emotions/caidao.gif)

![[dabian] [dabian]](/static/assets/comment/emotions/dabian.gif)

![[fanu] [fanu]](/static/assets/comment/emotions/fanu.gif)

![[guzhang] [guzhang]](/static/assets/comment/emotions/guzhang.gif)

![[se] [se]](/static/assets/comment/emotions/se.gif)

![[chajin] [chajin]](/static/assets/comment/emotions/chajin.gif)

![[bizui] [bizui]](/static/assets/comment/emotions/bizui.gif)

![[deyi] [deyi]](/static/assets/comment/emotions/deyi.gif)

![[ku] [ku]](/static/assets/comment/emotions/ku.gif)

![[huishou] [huishou]](/static/assets/comment/emotions/huishou.gif)

![[yinxian] [yinxian]](/static/assets/comment/emotions/yinxian.gif)

![[haixiu] [haixiu]](/static/assets/comment/emotions/haixiu.gif)

Impressive performance, worth the investment